Vom 7.10. bis zum 18.10.2019 haben Lucas Lehmacher und ich am Deutschen Forschungszentrum für Künstliche Intelligenz in Bremen ein zweiwöchiges Praktikum absolviert.

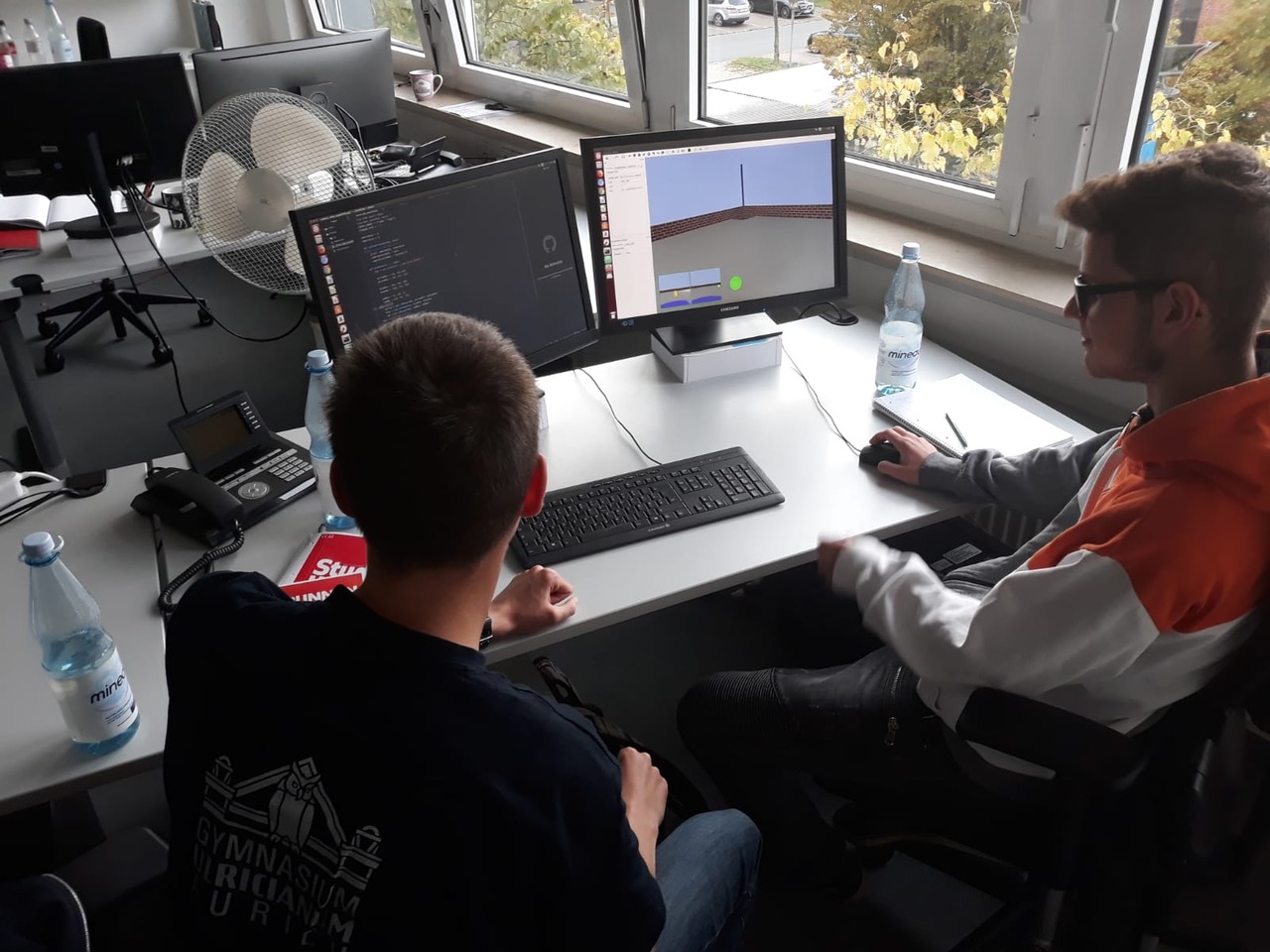

Dabei beschäftigten wir uns in der ersten Woche vor allem mit Robotersimulationen. Betreut wurden wir dabei von Herrn von Szadkowski, der uns schon vor Beginn des Praktikums nach unseren Interessen und Vorkenntnissen in der Robotik gefragt hatte und das Programm des Praktikums danach ausrichtete.

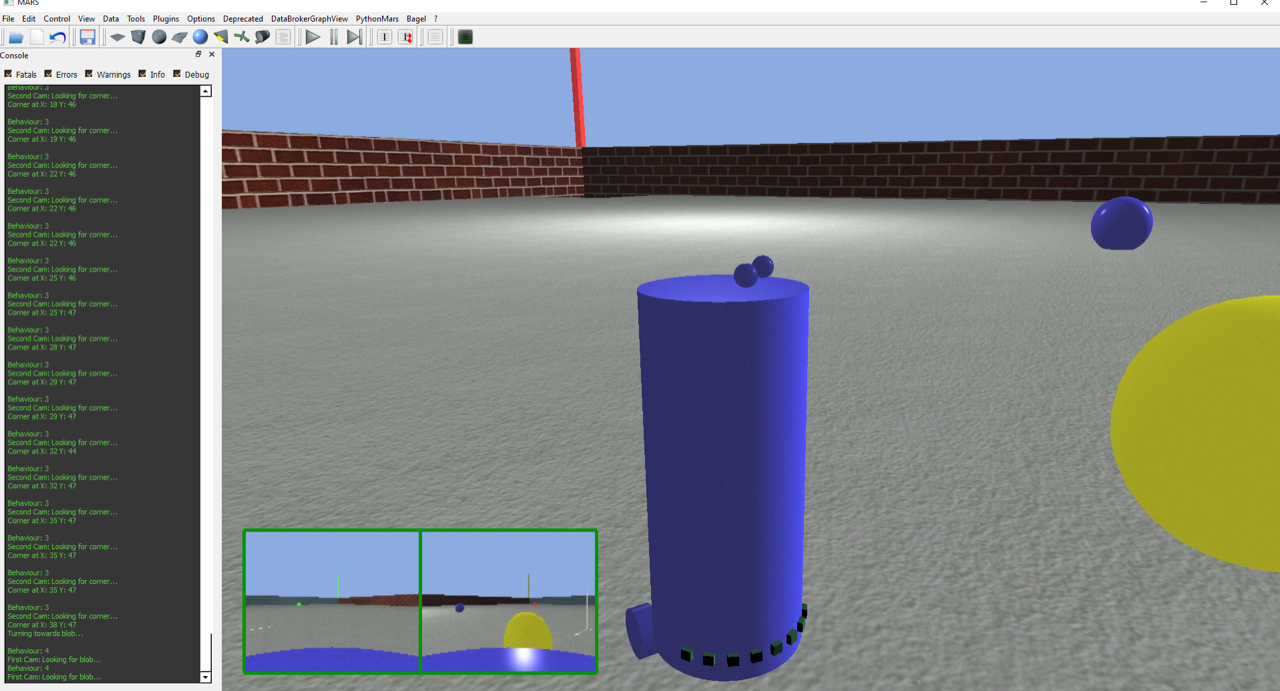

Nachdem wir den ersten Tag vor allem zur Eingewöhnung in die Simulationsumgebung und zur Programmierung relativ einfacher Roboterprogramme, wie einem Programm zum Ausweichen von Hindernissen und einem Wandfolgealgorithmus, verwendeten, stiegen wir am zweiten Tag in das weite Feld der Bilderkennung ein und versuchten einen Roboter zu programmieren, der mithilfe von zwei Kameras eine Reihe von unterschiedlich gefärbten Kugeln auf die dafür vorgesehenen gleichfarbigen Felder schieben sollte. Hier bestand die Schwierigkeit vor allem darin, die Kugeln trotz der teils stark unterschiedlichen Lichtverhältnisse gut erkennen zu können und dann das zur jeweiligen Kugel passende Feld zu finden.

Am vierten und fünften Tag arbeiteten wir weiter an dem Programm. Obwohl wir es schafften einen blob-detection-Algorithmus zur Erkennung der Kugeln zu implementieren, konnten wir das Programm in Bremen nicht ganz beenden. Wir haben das Programm jedoch nach dem Ende Praktikums zu Hause zu Ende entwickelt. Die zweite Woche begann mit einer Führung durch das DFKI.

Danach wurde uns von Mehmed Yüksel und Roman Szczuka der Bereich E-Mobility des DFKIs gezeigt. Dieser beschäftigt sich vor allem mit autonom fahrenden Autos. Wir durften sogar eine kleine Testfahrt in einem umgerüsteten E-Auto machen. Danach wurde uns die CAVE gezeigt, das Virtual Reality Lab des DFKIs, mit dem in Zukunft teilautonome Roboter ferngesteuert werden sollen. Dazu befand sich in der CAVE unter anderem ein omnidirektionales Laufband, das dem Benutzer ermöglicht sich in Virtual Reality genauso wie in der Realität laufend fortzubewegen. Nach einer kurzen Einführung durften wir die Ausrüstung sogar selbst ausprobieren.

Den folgenden Dienstag verbrachten wir vollständig damit, die Platine für einen Solartracker zusammenzubauen, der anschließend über einen Mikrocontroller (Arduino Nano) die Sonne verfolgen sollte. Zum Messen der Sonneneinstrahlung wurde ein Lighttracking-Modul mit vier Lichtsensoren (eines für jede Richtung) genutzt, um dann über zwei Servomotoren die Solarzelle auf die Lichtquelle ausrichten zu können.

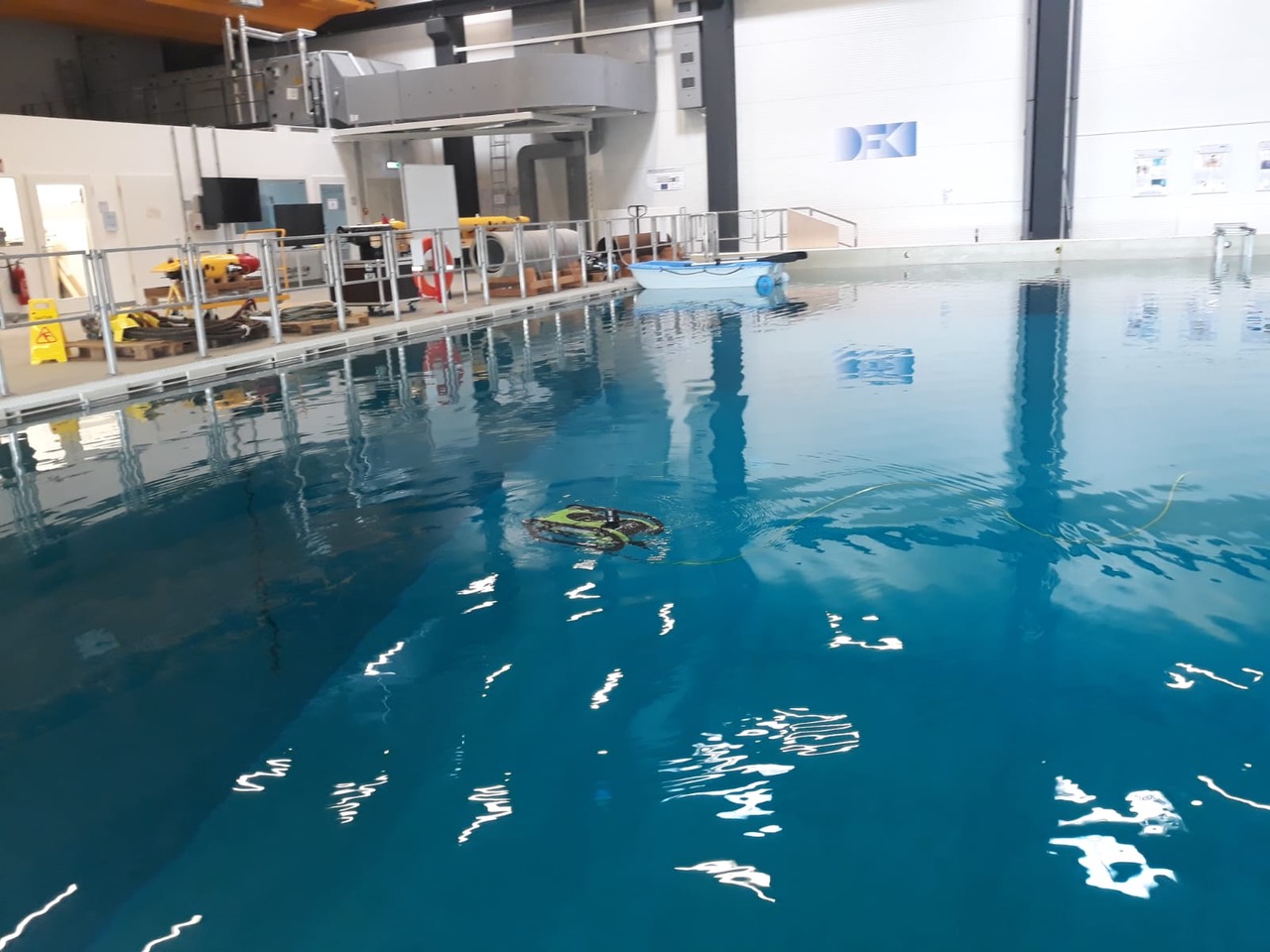

Am Mittwoch entwickelten wir mit Hilfe eines CAD-Programms dann die Grundplatte für den Solartracker, auf dem die einzelnen Bauteile, wie die Platine und die Solarzelle, später aufgeschraubt werden sollten. Nachmittags durften wir uns die Unterwasserroboter des DFKIs ansehen. Das DFKI hat dabei sowohl ROVs (Remotely Operated Vehicles), die ferngesteuert werden als auch AGVs (Automated Guided Vehicles), die weitgehend autonom agieren sollen, z. B. bei Missionen auf anderen Planeten. Dabei durften wir ein kleineres ROV sogar selbst steuern und dabei Ringe aus dem Wasserbecken des DFKIs herausholen. Der Donnerstag begann für uns mit einem EMG-Versuch (Elektromyografie). Dabei wurden unsere Muskelaktivität im Unterarmbereich beim Zerdrücken einer Wasserflasche gemessen und auf eine virtuelle Flasche übertragen, die auf einem Bildschirm angezeigt wurde und die wir somit auch virtuell „zerdrücken“ konnten.

Darüber hinaus konnten wir unter Zuhilfenahme derselben Technologie eine Partie des Kult-Computerspiels Pong spielen, indem wir durch Öffnen und Schließen unserer Hand die Schläger steuerten. Anschließend manövrierten wir unter Benutzung einer EEG-Kappe (Elektroenzephalografie) einen Roboter durch ein Labyrinth. Dazu mussten wir uns auf eines von vier unterschiedlichen Symbolen (dreh rechts, dreh links, einen Schritt nach vorn, drei Schritte nach vorn) fokussieren, die nacheinander auf einem Bildschirm aufblitzten. Sobald ein observiertes Symbol verschwindet, findet nämlich im Gehirn eine gewisse Neuronenaktivierung statt, die vom Computer erkannt werden kann. Die Vorbereitung für diesen Versuch (Aufsetzen der Kappe, Auftragen der Kontaktflüssigkeit zum Erkennen der Neuronensignale, Trainieren des Computers) war jedoch ziemlich zeitaufwändig, sodass nur ein Teil unserer Gruppe dieses Experiment durchführen konnte.

Am Nachmittag durften wir dann ein vom DFKI entwickeltes Exoskelett ausprobieren, das zur Behandlung von Schlaganfallpatienten entwickelt wurde. Die Patienten können mit Hilfe des Exoskeletts die Bewegung ihrer gelähmten Arme wieder erlernen. Es sind allerdings auch andere Anwendungsmöglichkeiten für Exoskelette denkbar, wie z. B. als Steuerungsplattform für humanoide Roboter. So können diesen Robotern z. B. spezielle Körperbewegungen zum Aufheben und Transportieren bestimmter Gegenstände antrainiert werden.

Am Freitagmorgen begannen wir dann mit der Programmierung unserer am Mittwoch zumindest hardwaretechnisch fertiggestellten Solartracker. Die Solarzelle des Solartrackers konnte dabei über zwei Servomotoren ausgerichtet werden (einen für die y- und einen für die x-Achse). Dabei mussten wir zunächst mit Hilfe des Lighttracking-Moduls die Richtung auf der y-Achse berechnen, aus der das Licht kommt und damit den ersten Servomotor einstellen. Danach mussten wir berechnen, aus welcher Richtung auf der x-Achse das Licht kommt, um damit den zweiten Servomotor einzustellen. Um diese Richtung zu erhalten, berechneten wir die Differenz zwischen den gegenüberliegenden Lichtsensoren auf dem Lighttracking-Modul. Dabei machten wir uns die Tatsache zunutze, dass diese Differenz gleich null sein muss, wenn das Licht direkt über dem Modul steht.

Nachmittags ging es für uns zum Cartesium, neben dem Neubau und dem Altbau des DFKIs ein weiteres Gebäude, in dem Experimente durchgeführt und Systeme entwickelt werden. Dort bekamen wir die Möglichkeit, einen Roboterarm zu steuern und mit diesem eine kleine Dominostrecke aufzubauen. Das System war dabei mit einer 3D-Maus relativ einfach zu bedienen, da die Steuerung der einzelnen Gelenke weitgehend von einer Software übernommen wurde und der Benutzer nur die Richtung angeben musste, in die sich der Greifer am Ende des Armes bewegen sollte.

Nach dieser letzten Station ging es abends mit dem Zug wieder nach Hause nach Ostfriesland. Wir können festhalten, dass uns unser zweiwöchiges Praktikum in Bremen sehr viel Spaß gemacht hat und das wir einen sehr umfangreichen Einblick in die Arbeitswelt von Wissenschaftlern im Robotikbereich bekommen konnten. Außerdem haben wir viel gelernt, z. B. wie man vor allem größere Projekte mit Hilfe von Git, einem Versionskontrollsystem, das die einzelnen Modifikationen und Änderungen an einem Programm aufzeichnet, gut dokumentieren kann. Darüber hinaus konnten wir unsere Fähigkeiten in der Programmiersprache Python erweitern.

Abschließend möchten wir uns bei der BBS Aurich, beim Gymnasium Ulricianum Aurich, bei den Auricher Wissenschaftstagen und bei unseren Betreuer*innen beim DFKI Bremen bedanken, die uns dieses Praktikum möglich gemacht haben.

Lucas Lehmacher

Tido Specht